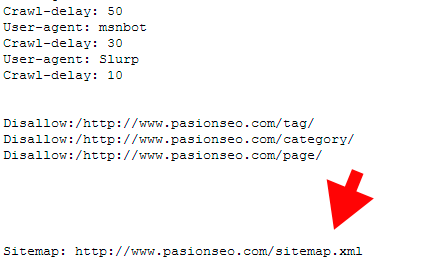

Es posible que no lo sepas, pero tu archivo Sitemap debe aparecer referenciado en tu archivo Robots. Pero, bueno primero hablemos un poco sobre ambos para determinar su importancia en el posicionamiento.

Sitemap:

El mapa del sitio se utiliza para indicarle a Google, las paginas que encontrará en nuestro sitio web este archivo posee extensión .xml siendo el archivo concreto Sitemap.xml

Cuando posee extensión .html es decir, Sitemap.html es para el usuario, mediante el mismo le mostramos al visitante donde se encuentra cada página para que pueda acceder más rápido a la información.

Robots:

Por el contrario el Robots.txt es un archivo de texto, de hecho es el primer archivo visitado por Google cuando entra a nuestro sitio web.

Con este lo que hacemos es decirle a Google que paginas serán mostradas e indexadas en sus servidores para que aparezcan en los resultados de búsquedas.

Recuerda agregar tu Sitemap al Robots como puedes ver en la imagen de más abajo, por cierto si lo deseas puedes revisar nuestro Robots.txt

0 Comments